Matematyka i muzyka są ściśle powiązane przez rytm, harmonię i struktury, które wykorzystują matematyczne wzory i proporcje do tworzenia estetycznych i emocjonalnych doznań. Z nieśmiałą ekscytacją przedstawiam Wam moją pierwszą poważniejszą kompozycję, w której starałem się uchwycić te połączenia. 🙂

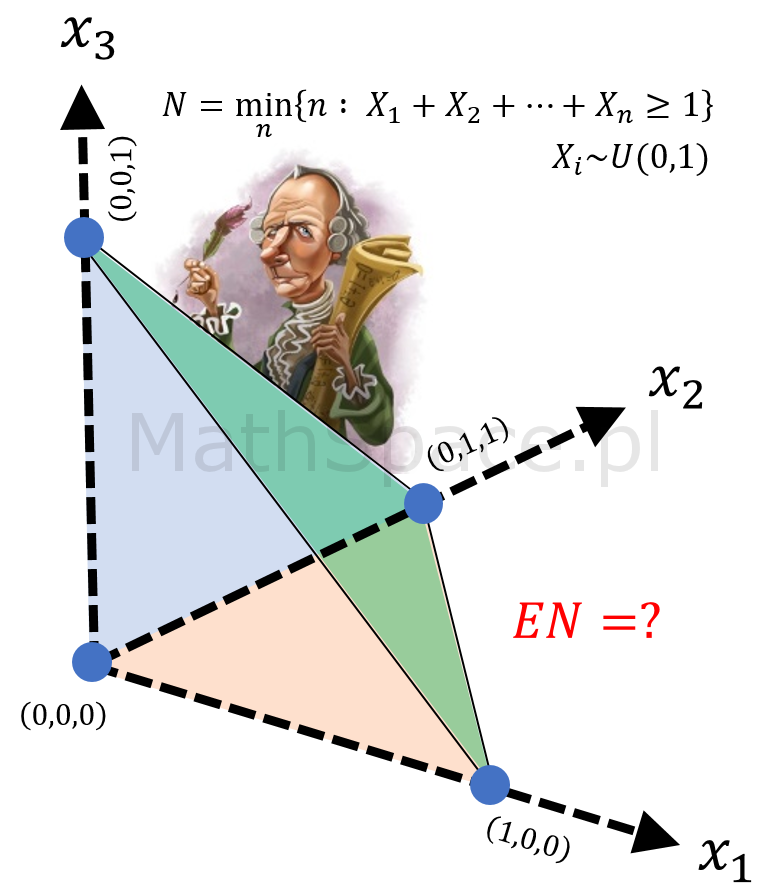

Liczba e ukryta w sumie rozkładów jednostajnych

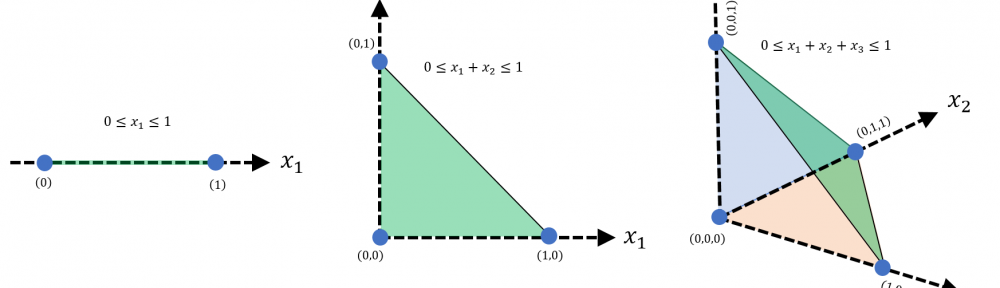

Rozkład jednostajny na odcinku $(0,1)$, chyba najprostszy z możliwych rozkładów ciągłych, z pozoru niezbyt interesujący, a jednak 🙂 Dziś ciekawostka wiążąca rozkład sumy rozkładów jednostajnych z liczbą Eulera e.

Rozkład jednostajny ciągły na odcinku (a,b)

Rozkład jednostajny ciągły na odcinku $(a,b)$ jest opisany poniższą funkcją gęstości.

$$f(x)=\begin{cases}\frac{1}{b-a}&&\text{dla }a\leq x\leq b\\0&&\text{w p.p.}\end{cases}$$

Pisząc $X\sim U(a,b)$ oznaczamy, że zmienna losowa $X$ ma rozkład jednostajny ciągły na odcinku $(a,b)$. Jest to rozkład ciągły, zatem przyjęcie wartości $0$ lub $\frac{1}{b-a}$ w punktach $x=a$ i $x=b$ jest umowne i nie ma zwykle wpływu na własności i rozważania.

Liczba π (Pi) ukryta w liczbach pierwszych

Liczba $\pi$ ukryta w liczbach pierwszych? Jak to możliwe? Przecież liczby pierwsze to „chaos”, a $\pi$ ma ścisły związek z najbardziej regularnym obiektem geometrycznym – tzn. z okręgiem / kołem.

Czym jest $\pi$?

- $\pi$ to stosunek obwodu koła do jego średnicy.

- $\pi$ to pole powierzchni koła o promieniu $1$.

- $\pi$ to połowa obwodu koła o promieniu $1$.

- $\pi$ to $\frac{1}{4}$ pola powierzchni sfery o promieniu $1$.

- $\pi$ to $\frac{3}{4}$ objętości kuli o promieniu $1$.

- $k\pi$ dla całkowitych $k$ to miejsca zerowe funkcji $\sin x$.

- … i wiele innych …

Czym są liczby pierwsze?

- Liczba pierwsza to liczba naturalna $n\in\mathbb{N}$ większa od $1$, której jednymi dzielnikami są $1$ oraz $n$.

- Liczby pierwsze to „atomy” w teorii liczb, tzn. każdą liczbę naturalną można rozłożyć na iloczyn liczb pierwszych.

- Rozmieszczenie liczb pierwszych wśród liczb naturalnych spełnia pewne zależności statystyczne, jednak nie jest znany żaden precyzyjny wzór dla określenia $n-tej$ liczby pierwszej. Ciekawskich odsyłam do artykułu „Prime-counting function”.

Genialny wzór Taylora – czyli o informacji zakodowanej w pochodnych

„Co to jest różniczka? – zapytano matematyka.

Różniczka to wyniczek odejmowanka – odpowiedział”

🙂

Wzór Taylora to jeden z elementów, które stanowią esencję rachunku różniczkowego i całkowego. Oto, w magiczny sposób, na bazie sekwencji informacji o funkcji, dotyczących tylko jednego jej wybranego punktu, możliwe jest bardzo precyzyjne odtworzenie zmienności funkcji w pobliżu ustalonego punktu. Wzór Taylora, nazywamy często rozwinięciem Taylora funkcji $f(x)$ w otoczeniu punktu $x_0$, faktycznie „rozwija” funkcję do postaci sumy funkcji elementarnych $a_n(x-x_0)^n$, stanowiących atomy wielomianów. W efekcie otrzymujemy nie tylko efektywną aproksymację wartości funkcji, ale również nową „łatwiejszą” jej formę.

Wielomian Taylora

Twierdzenie Taylora: Dla funkcji $f:\mathbb{R}\to\mathbb{R}$ $n$-razy różniczkowalnej $(n\geq 1)$ w punkcie $x_0\in\mathbb{R}$, istnieje funkcja $h_n:\mathbb{R}\to\mathbb{R}$, że

$$f(x)=\underbrace{\displaystyle\sum_{k=0}^n\frac{f^{(k)}(x_0)}{k!}(x-x_0)^k}_{wielomian-aproksymacja~f(x)}+\underbrace{h_n(x)(x-x_0)^n}_{reszta}$$

$$f(x)=f(x_0)+\frac{f^{(1)}(x_0)}{1!}(x-x_0)^1+\frac{f^{(2)}(x_0)}{2!}(x-x_0)^2+\ldots$$

$$\ldots+\frac{f^{(n)}(x_0)}{n!}(x-x_0)^n+h_n(x)(x-x_0)^n$$

oraz

$$\displaystyle\lim_{x\to x_0}h_n(x)=0$$

Przez $f^{(k)}(x)$ oznaczamy pochodną rzędu $k$ funkcji $f(x)$.

Twierdzenie Taylora nosi nazwę od angielskiego matematyka Brooka Taylora, który opracował je w 1712 roku. Samą własność wcześniej odkrył James Gregory – dokonał tego w 1671 roku.

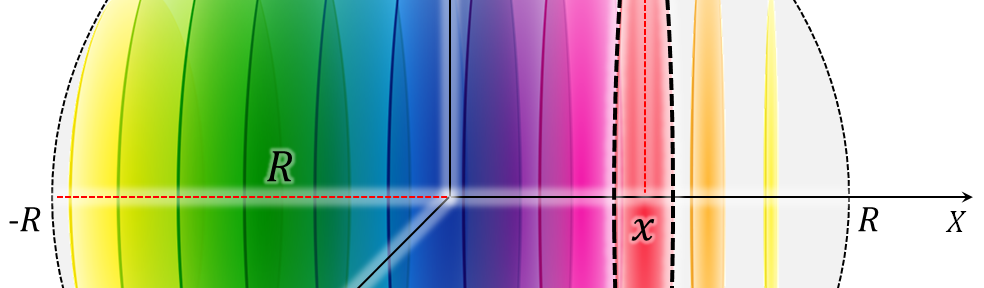

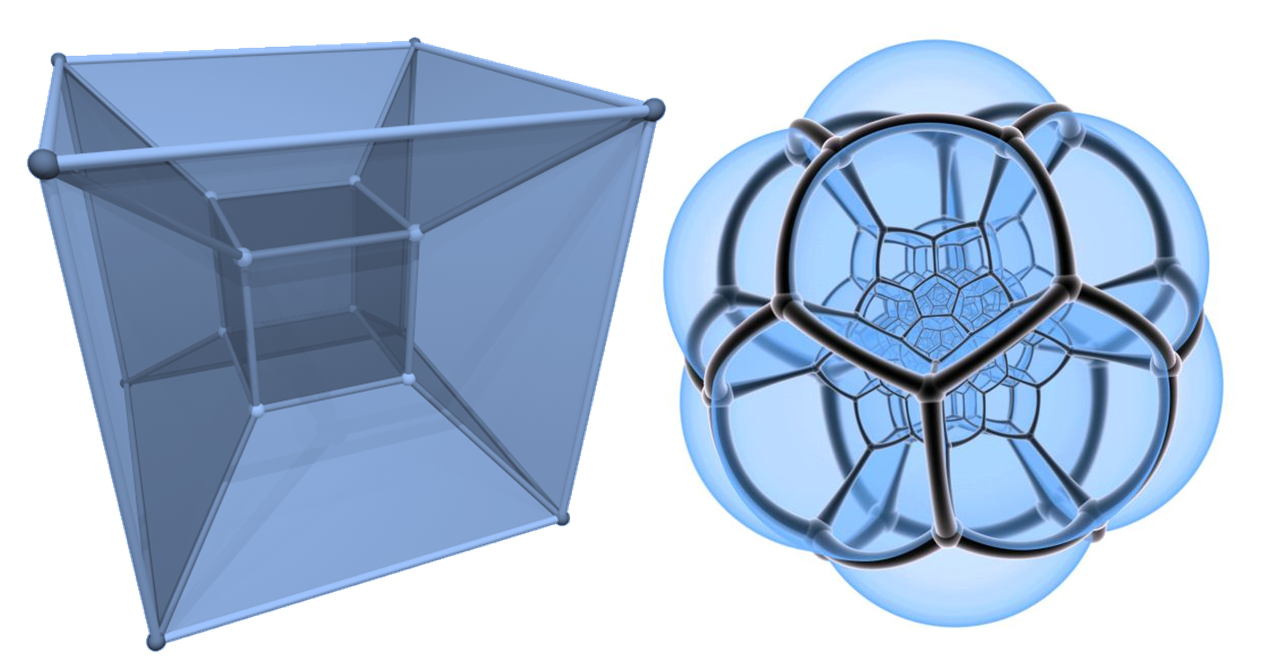

Egzotyczna hiperkula – czyli o pomiarach w przestrzeni wielowymiarowej

„Jak oczami wyobraźni zobaczyć 4 wymiary? – zapytano matematyka.

To proste – odpowiedział – wystarczy wyobrazić sobie n-wymiarów i podstawić n=4″

🙂

Dzisiejszy wpis poświęcę pomiarom odległości, powierzchni i pojemności w przestrzeniach wielowymiarowych. N-wymiarowa przestrzeń euklidesowa dostarcza dosyć oczywistą metrykę – a przez to wydawałoby się – bardzo intuicyjną. To wrażanie jest jednak mylne, co łatwo pokazać analizując wpływ zwiększania liczby wymiarów na dokonywane pomiary. Jak w zależności od liczby wymiarów zmienia się powierzchnia i objętość kuli? Analogicznie – jak zmienia się maksymalna odległość pomiędzy wierzchołkami kostki? Obiecuję – odpowiedzi będą zaskakujące 🙂

Możesz mieć wrażenie, że to wyłącznie abstrakcyjne rozważania. Czy na pewno? Ja w zasadzie na co dzień analizuję Klientów opisanych szeregiem miar. Poszukiwanie podobieństw, skupień, segmentów czy „najbliższych sąsiadów” niemal w całości opiera się na wielowymiarowej metryce euklidesowej. Zapraszam do pogłębienia wiedzy w tym obszarze:-) Zapewniam – warto!

Zero Silnia – czyli dlaczego 0!=1?

Artykuł „Mnożenie liczb ujemnych – czyli dlaczego minus razy minus daje plus?” cieszy się ogromnym zainteresowaniem (np. w piątek 21.10.2016 został pobity rekord, mianowicie tylko w tym jednym dniu 350 unikalnych użytkowników zapoznało się z treścią wpisu). Będąc świadomym, że dla wielu z Was ważne jest zrozumienie motywacji stojącej za podstawowymi definicjami, postanowiłem rozpocząć nowy cykl „Dlaczego?”. Nowa seria skupi się na powszechnie znanych zagadnieniach, których wyjaśnienie nie jest już takie oczywiste. 🙂 Dziś na tapet idzie zero silnia! Przedstawię kilka argumentacji – w tym coś dla mniej i coś dla bardziej zaawansowanych! Będzie hardcorowo 🙂

Silnia – definicja

Generatywna Sztuczna Inteligencja: Jak stworzyć własnego co-pilota do kreowania i zarządzania produktami i usługami na każdym poziomie organizacji

Czy zastanawialiście się, jak język naturalny może demokratyzować technologię? Albo jak generatywna sztuczna inteligencja może wspomóc różne dziedziny biznesu – od analizy danych po zarządzanie produktem? W trakcie prezentacji zgłębiam moc kontekstu, który zmienia obecne paradygmaty. Przekonuję jak era copilot’ów wpłynie na naszą codzienną pracę. Pomagam również odkryć jakie kompetencje będą potrzebne w świecie napędzanym przez AI. Od copilota programisty, przez analityka danych, aż po CEO – dowiedz się, jak sztuczna inteligencja może stać się Twoim najcenniejszym współpracownikiem!

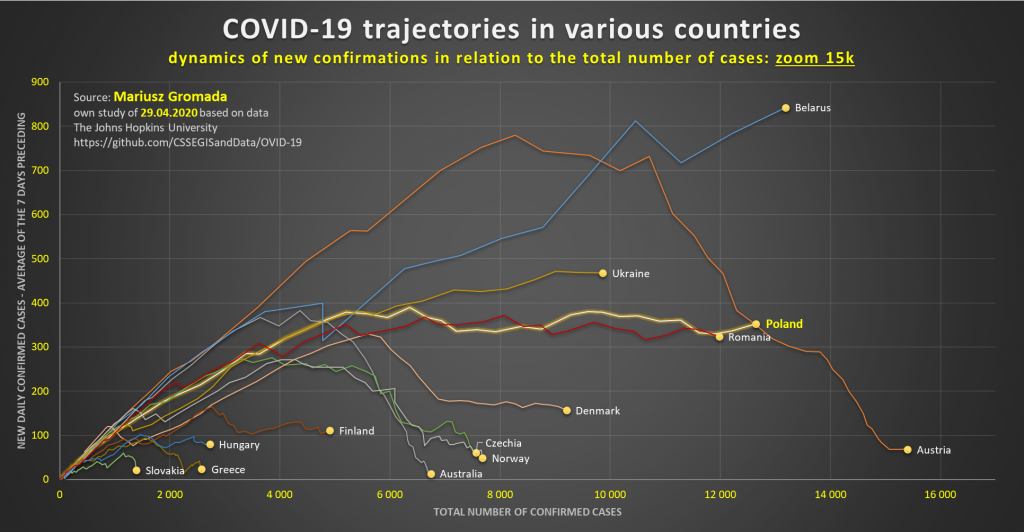

Continue readingTrajektorie przebiegu COVID-19 w różnych krajach

Symulacja procesu epidemii – Grant Sanderson – 3Blue1Brown

Matematyka w obrazkach #26 – Sowa Lorenzowa :-)

W „matematyce w obrazkach” ponownie grafika wykonana na bazie Atraktora Lorenza – to bardzo wdzięczny motyw! Oto Sowa Lorenzowa 🙂

Chcesz zobaczyć poprzednie grafiki? Kliknij tutaj.

Pozdrowienia,

Mariusz Gromada

O liczbie e – Część 2 – Dlaczego jest tak „naturalna” – Funkcja wykładnicza i pochodna eˣ

„Plaża, piękna pogoda, sielanka i relaks! Różne funkcje wypoczywają. Nagle … popłoch, panika! Funkcje uciekają. Tylko jedna nadal się opala.

– Co robisz? Uciekaj! Nadchodzi operator różniczkowy!

– Nie boję się, jestem $e^x$.

I tak spokojna $e^x$ została. Wpada operator.

– Wrrr! Teraz Cię zróżniczkuję! Wrrr!

– A proszę bardzo – jestem $e^x$ – nic mi nie grozi.

– Kochana, ja różniczkuję po $dy$”

Ten iście „nerdowski” dowcip całkiem dobrze rozpoczyna kolejną część serii „o liczbie e”. Na bazie pochodnej przedstawię dodatkowe argumenty „dlaczego?” liczba e jest tak naturalna. Zaczynamy od powtórki podstaw w zakresie potęgowania. Prawdopodobnie zaskoczę Cię już samą definicją funkcji wykładniczej $a^x$ 🙂

Definicja funkcji wykładniczej na bazie potęgowania

O liczbie e – Część 1 – Dlaczego jest tak „naturalna” – Procent składany

Funkcja wykładnicza i logarytm wprowadzane są w szkole średniej (przynajmniej tak było w moim przypadku). Zazwyczaj wtedy poznajemy liczbę $e$, którą magicznie nazywa się podstawą logarytmu naturalnego.

$$e\approx 2.718\ldots$$

Nazwa dobrana jest świetnie, niestety nikt nie tłumaczy dlaczego tak właściwie jest. Cała sprawa jest niezwykle ciekawa, jej wyjaśnienie to temat nowej serii artykułów „o liczbie e”. Tym samym wzbogacam cykl „dlaczego?”. Dowody przeprowadzę „metodą elementarną” – wszak chodzi o „pierwotność / naturalność” $e$. Będzie kilka dużych „odcinków” – zapraszam 🙂

Nota historyczna

Liczba e pojawia się w wielu dziedzinach. W matematyce jest wszechobecna! Z powodzeniem dorównuje liczbie $\pi$. Analiza matematyczna (w szczególności rachunek różniczkowy i całkowy, równania różniczkowe), funkcje specjalne, analiza zespolona, rachunek prawdopodobieństwa, statystyka matematyczna – to najbardziej wyraziste przykłady. W innych naukach ścisłych (np.: ekonomia, fizyka, biologia) liczba e pojawia się w wielu ważnych równaniach, w tym: równanie przewodnictwa cieplnego, wzór barometryczny, rozpady promieniotwórcze, fazory, funkcja falowa w mechanice kwantowej, wzrost populacji, procent składany.

Pierwsze informacje na temat liczby e pojawiły się w 1618 roku. Opublikował je John Napier, przygotowując tabele logarytmów. Praca nie zawierała samej stałej, prezentowała niektóre wartości logarytmów na bazie e. Liczbę e w jej dzisiejszej postaci odkrył Jacob Bernoulli. Dokonał tego w 1683 roku analizując własności procentu składanego. Pierwsze udokumentowane wykorzystanie liczby e, wtedy oznaczanej przez b, pojawiło się w latach 1690-1691 (Gottfried Leibniz, Christiaan Huygens). Wykorzystanie stałej znacząco rozwinął Leonhard Euler oznaczając ją w 1727 roku do dziś wykorzystywanym symbolem $e$.

Procent składany

Matematyka w obrazkach #25 – Duch – Atraktor Lorenza :-)

Grafika wykonana na bazie Atraktora Lorenza – świetne wzbogacenie cyklu „Matematyka w obrazkach” 🙂

Polecam poniższą animację – 500 tysięcy ciasno upakowanych cząstek rozchodzi się w chaos. Cząstki to punkty z rozkładu Gaussa z odchyleniem standardowym 0.01. W miarę upływu czasu cząstki podążają za dynamiką Lorenza.